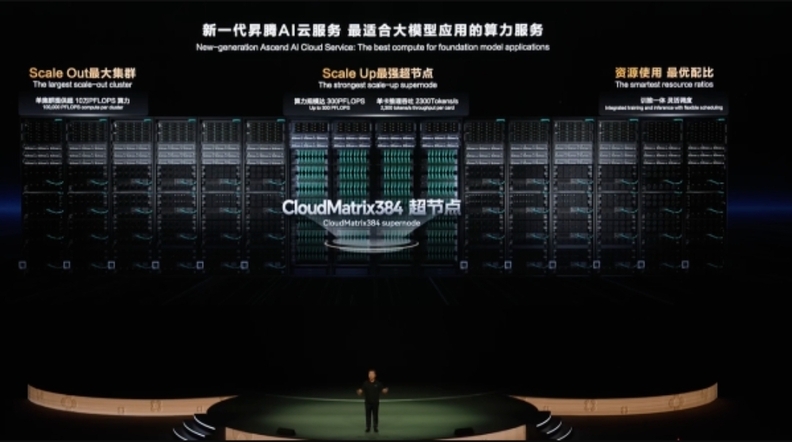

더지엠뉴스 구태경 기자 | 화웨이(华为, Huawei)가 AI 클라우드 서비스 시장에 초대형 컴퓨팅 파워를 탑재한 신제품을 선보이며 기술 경쟁에 본격 가세했다. 최신 '클라우드메이트릭스384(CloudMatrix384)' 슈퍼노드 아키텍처 기반으로 최대 16만장 카드가 연결되는 대형 클러스터 서비스가 정식 출시에 들어갔다.

20일 열린 ‘화웨이 개발자 컨퍼런스 2025(HDC 2025)’에서 장핑안(张平安, Zhang Ping’an) 화웨이 이사 겸 화웨이 클라우드 컴퓨팅 CEO는 “새로운 AI 클라우드 서비스가 대규모 모델 학습 및 추론 수요에 대응하기 위한 기술적 한계를 돌파했다”고 발표했다.

장핑안 CEO는 “기존 아키텍처로는 폭증하는 AI 연산 수요를 감당할 수 없었다”며, “클라우드메이트릭스384 슈퍼노드는 384개 어센드(Ascend) NPU와 192개 쿤펑(Kunpeng) CPU를 MatrixLink 고속 네트워크로 상호 연결해 초대형 AI 서버를 구성한다”고 설명했다.

이번 슈퍼노드는 단일 카드당 추론 처리량이 초당 2,300 토큰까지 향상됐다. 특히 하이브리드 전문가(MoE, Mixture of Experts) 대형 모델 추론을 위한 ‘1카드 1전문가’ 병렬 구조를 지원, 슈퍼노드 한 개로 384명의 전문가 추론이 가능하다.

자원 활용률도 크게 개선됐다. 1카드 1컴퓨팅 작업 구조와 병렬 처리 최적화를 통해 컴퓨팅 파워 유효 활용률(MFU)은 50% 이상 향상됐으며, 작업 대기 시간 역시 대폭 단축됐다.

수조~수십조 개 매개변수를 요구하는 AI 모델의 경우, 최대 432개 슈퍼노드를 연결해 최대 16만장의 카드 클러스터 구성이 가능하다. 학습과 추론의 컴퓨팅 파워를 유연하게 배치하는 ‘주간 학습-야간 추론’ 방식도 지원한다.

현재까지 화웨이 Ascend AI 클라우드 서비스는 1,300곳 이상의 고객에게 제공되고 있으며, 주요 기업과 연구기관 사례도 다수 공개됐다.

중국과학원은 클라우드메이트릭스384 슈퍼노드를 활용해 독자 AI 연구모델 프레임워크를 구축하고 고성능 외산 AI 플랫폼 의존도를 줄였다. 실리콘모빌리티는 해당 슈퍼노드 기반으로 수백만 사용자 대상 딥시크(DeepSeek) V3·R1 추론 서비스를 고속화했고, 밍비 인텔리전스(Mianbi Intelligence)는 소형 강철 대포 모델 성능을 2.7배 향상시켰다.

또한, 360 나노 AI 검색 서비스에도 도입돼 AI 기반 초고속 검색 플랫폼을 지원 중이다.

장핑안 CEO는 이날 ‘판구(盘古, Pangu) 빅 모델 5.5’의 출시도 함께 발표했다. 판구 빅 모델은 NLP(자연어 이해), CV(컴퓨터 비전), 예측, 멀티모달리티, 과학 컴퓨팅 등 5대 핵심 영역에서 업그레이드됐다.

새롭게 공개된 718B 딥씽킹 모델은 256명의 전문가가 포함된 MoE 기반 대형 모델로, 지식 추론, 도구 호출, 수학 연산 성능에서 업계 선도 수준에 도달했다.

판구 모델은 Ascend 친화적 학습 최적화 구조와 일반 계산 마스킹, 글로벌 동적 밸런싱, MoGE(그룹화 혼합 전문가) 알고리즘으로 효율성을 강화했으며, MFU와 단일 카드 추론 성능 역시 업계 최고 수준에 도달한 것으로 평가됐다.

업계 관계자는 “화웨이가 자체 아키텍처 기반으로 AI 클라우드 시장에서 본격적인 기술적 독립성을 확보했다”고 분석했다.